Wat als je grootste bondgenoot in digitale beveiliging ook je grootste bedreiging zou kunnen zijn?

AI is overal om ons heen en helpt ons bij het detecteren van cyberbedreigingen sneller dan ooit. Maar cybercriminelen zijn bezig dezelfde technologie te gebruiken om hun aanvallen geavanceerder, sneller en gevaarlijker te maken. Met de Cybersecurity Awareness Month in oktober is het cruciaal om te begrijpen hoe AI zowel een zegen als een gevaar kan zijn in de strijd tegen cybercriminaliteit. Door de juiste kennis te vergaren, kun je je organisatie beter voorbereiden op de toekomst en je wapenen tegen deze nieuwe generatie cyberdreigingen.

In deze blog ontdek je hoe AI en cybersecurity elkaar versterken, maar ook welke risico’s er zijn wanneer hackers dezelfde technologie inzetten. We verkennen aansprekende voorbeelden van AI, zoals adversarial attacks, en laten zien hoe jij jezelf kunt beschermen met de juiste inzichten.

Hoe AI Cybersecurity kan Versterken

De digitale wereld is in een constante staat van evolutie. Cyberaanvallen worden slimmer, sneller en vaker ingezet dan ooit tevoren. Hier komt AI om de hoek kijken als een krachtig hulpmiddel in de verdediging tegen deze aanvallen. Een van de grootste krachten van AI ligt in zijn vermogen om patronen te herkennen in enorme hoeveelheden data – iets wat voor menselijke analisten moeilijk en tijdrovend zou zijn.

AI speelt een cruciale rol in intrusion detection systems (IDS), die continu netwerkverkeer monitoren en met behulp van machine learning afwijkingen opsporen, zoals verdachte inlogpogingen of ongebruikelijk grote gegevensoverdrachten. AI leert wat normaal gedrag is en detecteert afwijkingen die kunnen wijzen op een dreiging, waarna het beveiligingsteams kan waarschuwen of zelfs automatisch actie kan ondernemen om schade te beperken. Dit verkort de reactietijd aanzienlijk en voorkomt dat bedreigingen ongemerkt blijven.

Daarnaast herkent AI malware door patronen te identificeren die op kwaadaardige activiteiten wijzen. AI doorzoekt snel grote hoeveelheden data en herkent subtiele variaties die door hackers worden gebruikt om detectie te omzeilen, waardoor beveiligingsefficiëntie toeneemt.

De Keerzijde: Hoe Hackers AI Kunnen Gebruiken

Net zoals AI een bondgenoot kan zijn voor beveiligingsprofessionals, kunnen hackers het gebruiken om hun aanvallen te verbeteren. Een van de gevaarlijkste ontwikkelingen op dit gebied is het gebruik van AI om aanvallen te automatiseren. Hackers kunnen met behulp van machine learning-technieken kwetsbaarheden in systemen opsporen, malware automatisch aanpassen of phishing-e-mails nauwkeurig afstemmen op specifieke doelwitten.

Een ander verontrustend voorbeeld is de opkomst van AI-gegenereerde deepfakes. Met behulp van AI kunnen cybercriminelen realistisch ogende video’s en geluidsopnamen creëren die vrijwel niet van echt te onderscheiden zijn. Deze deepfakes kunnen worden gebruikt voor CEO-fraude, waarbij een valse video of stemopname een medewerker overtuigt om gevoelige informatie te delen of geld over te maken naar de rekening van criminelen.

Gelukkig zijn beveiligingsexperts niet machteloos tegenover deze gevaren. Door te begrijpen hoe hackers AI kunnen gebruiken, kun je je systemen beter beschermen tegen dergelijke aanvallen. Dit begint met het implementeren van sterke beveiligingsmaatregelen en het regelmatig trainen van medewerkers om verdachte activiteiten te herkennen.

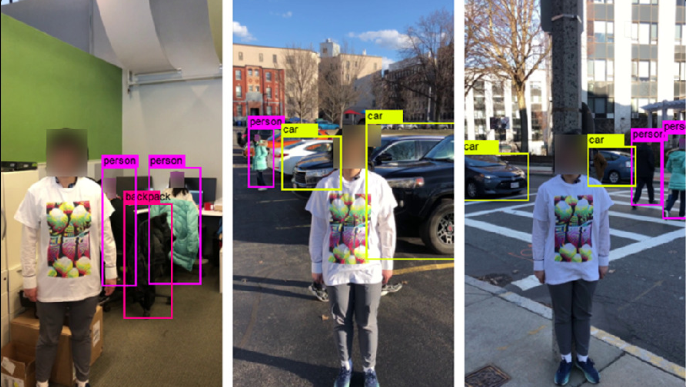

Adversarial Attacks: Hacken van AI-systemen

Naast het gebruik van AI om traditionele cyberaanvallen te verbeteren, kunnen kwaadwillenden AI-systemen ook rechtstreeks aanvallen via zogenaamde adversarial attacks. Bij deze aanvallen worden subtiele verstoringen toegevoegd aan de inputdata die AI-systemen gebruiken, waardoor deze systemen foute beslissingen nemen. Deze verstoringen zijn voor het menselijk oog meestal onzichtbaar, maar voor de AI maken ze een groot verschil.

Een treffend voorbeeld hiervan is het experiment met het adversarial attack T-shirt. Onderzoekers ontwikkelden een speciaal T-shirt met een patroon dat, wanneer het werd gedragen, persoonsherkenningssoftware volledig misleidde. Voor de AI-systemen die waren getraind om personen te herkennen, werd de persoon die het T-shirt droeg óf niet herkend, óf als iemand anders geclassificeerd, terwijl een mens gewoon een persoon in een T-shirt zou zien.

Bron: https://towardsdatascience.com/avoiding-detection-with-adversarial-t-shirts-bb620df2f7e6

Stel je voor dat dit soort aanvallen wordt toegepast in een bedrijf met een geavanceerd beveiligingssysteem op basis van gezichtsherkenning. Een aanvaller zou een adversarial patch kunnen ontwikkelen — bijvoorbeeld een patroon op een kledingstuk of bril — om de AI te misleiden. Hierdoor zou de AI de persoon verkeerd classificeren, bijvoorbeeld als iemand met volledige toegang, terwijl dat niet het geval is.

De gevolgen van deze aanval zijn verstrekkend:

- Ongeautoriseerde toegang tot beveiligde ruimtes.

- Identiteitsdiefstal waarbij de aanvaller zich voordoet als een medewerker met hoge machtigingen.

- Industriële spionage, waarbij concurrenten toegang krijgen tot gevoelige bedrijfsinformatie.

Maar deze aanvallen gaan verder dan alleen fysieke misleiding. In meer subtiele gevallen kan een adversarial attack ook data in AI-modellen manipuleren. Denk aan een machine learning-systeem dat wordt gebruikt voor kredietbeoordeling: door kleine wijzigingen in de trainingsdata toe te voegen, kunnen aanvallers het systeem beslissingen laten nemen die normaal zouden worden afgewezen, zoals het goedkeuren van frauduleuze aanvragen.

De zakelijke impact van deze aanvallen kan enorm zijn:

- Financiële verliezen door diefstal of spionage.

- Reputatieschade, vooral als de inbreuk openbaar wordt.

- Juridische gevolgen door het lekken van klantgegevens of niet-naleving van privacywetgeving.

- Verlies van vertrouwen onder medewerkers, klanten en partners.

Dit toont aan hoe kleine, onzichtbare manipulaties van AI-systemen, of ze nu fysiek of datagedreven zijn, ernstige gevolgen kunnen hebben voor de beveiliging en bedrijfsvoering. Het onderstreept de noodzaak van robuuste AI-systemen die bestand zijn tegen dit soort verstoringen, zodat bedrijven beter beschermd zijn tegen aanvallen.

De Toekomst van AI en Cybersecurity: Samen Sterker of Kwetsbaarder?

AI biedt enorme kansen voor de beveiliging van onze digitale wereld. Het vermogen om patronen te herkennen, bedreigingen in real-time te analyseren en razendsnel te reageren, maakt AI een onmisbaar hulpmiddel in de strijd tegen cybercriminaliteit. Maar zoals elke krachtige technologie, brengt AI ook nieuwe risico’s met zich mee.

De toekomst van AI en cybersecurity hangt af van onze bereidheid om continu te leren en ons aan te passen. Door jezelf te verdiepen in AI en te begrijpen hoe deze technologie werkt, kun je jezelf en je organisatie niet alleen beter beschermen, maar ook proactief inspelen op de nieuwste ontwikkelingen. AI kan dan niet alleen een verdediging zijn, maar ook een manier om altijd een stap voor te blijven op cybercriminelen.

Het is cruciaal dat we investeren in bewustwording en educatie over AI en cybersecurity. Met de juiste kennis kun je niet alleen voorkomen dat je kwetsbaar wordt voor aanvallen, maar ook de technologische kansen van AI benutten.

Wil je meer inzicht krijgen in hoe AI de toekomst van cybersecurity beïnvloedt en hoe jij voorbereid kunt zijn op deze ontwikkelingen? Neem gerust contact met mij op. Ik help je graag om een helder beeld te krijgen van de mogelijkheden en uitdagingen van AI, zodat je beter geïnformeerde beslissingen kunt nemen in de snel veranderende digitale wereld.